В Google научили нейросеть отделять объект от фона

В Google научили нейросеть отделять объект от фона

В Google разработали нейросеть, с высокой точностью отделяющую объект от фона на изображении. Модель уже используется в портретном режиме съемки на смартфоне Pixel 6.

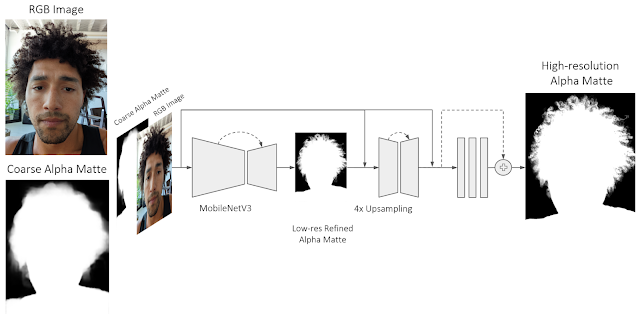

При классической сегментации изображения каждый пиксель относится либо к переднему, либо к заднему плану. Такой тип сегментации плохо работает для мелких деталей, например, волос. В подходе Google интенсивность каждого пикселя представляет собой линейную комбинацию переднего плана и фона, что позволяет точно определить границы объекта и, следовательно, улучшить качество селфи в портретном режиме.

Разработчики обучили сверточную нейронную сеть, состоящую из последовательности блоков энкодер-декодер. Сначала с помощью нейросети Google MobileNetV3 и неглубокого (т. е. состоящего из небольшого количества слоев) декодера формируется приближенная оценка линейной комбинации. Затем происходит уточнение линейной комбинации с помощью дополнительной обработки неглубоким блоком энкодер-декодер и серией остаточных блоков.

Модель была обучена на датасете Light Stage, состоящем из высококачественных пар изображений фон/фон+человек.

Нейросеть работает в реальном времени на Pixel 6 с использованием Tensorflow Lite (решение для машинного обучения для мобильных платформ).

Источник: Neurohive

Сообщение В Google научили нейросеть отделять объект от фона появились сначала на Журнал Digital World - новости, тесты, обзоры телефонов, планшетов, ноутбуков.

| Карта сайта:

| Карта сайта: